Badacze z Cambridge ostrzegają przed psychologicznymi zagrożeniami związanymi z „martwymi robotami” – sztuczną inteligencją naśladującą zmarłe osoby, wzywając do stosowania standardów etycznych i protokołów zgody, aby zapobiegać nadużyciom i zapewniać interakcję pełną szacunku.

Według badaczy z Uniwersytet Cambridgesztuczna inteligencja, która umożliwia użytkownikom prowadzenie rozmów tekstowych i głosowych z utraconymi bliskimi, stwarza ryzyko wyrządzenia krzywdy psychicznej, a nawet cyfrowego „nawiedzenia” osób pozostawionych bez standardów bezpieczeństwa projektowego.

„Deadboty” lub „Griefboty” to chatboty oparte na sztucznej inteligencji, które symulują wzorce językowe i cechy osobowości zmarłych, wykorzystując pozostawione przez nich cyfrowe ślady. Niektóre firmy już oferują takie usługi, zapewniając zupełnie nowy rodzaj „obecności pośmiertnej”.

Etycy sztucznej inteligencji z Leverhulme Centre for the Future of Intelligence w Cambridge zarysowują trzy scenariusze projektowania platform, które mogą pojawić się w ramach rozwijającego się „cyfrowego przemysłu życia pozagrobowego”, aby pokazać potencjalne konsekwencje nieostrożnego projektowania w obszarze sztucznej inteligencji, który określają jako „wysokiego ryzyka” .”

Niewłaściwe wykorzystanie chatbotów AI

Wyniki badania opublikowane w czasopiśmie Filozofia i technologiapodkreśla, że firmy mogą wykorzystywać martwe roboty do potajemnego reklamowania produktów użytkownikom na wzór zmarłej bliskiej osoby lub niepokoić dzieci, upierając się, że zmarły rodzic nadal jest „z tobą”.

Kiedy żywi zarejestrują się, aby zostać wirtualnie odtworzeni po ich śmierci, powstałe chatboty mogą zostać wykorzystane przez firmy do spamowania rodziny i przyjaciół, którzy przeżyli, za pomocą niechcianych powiadomień, przypomnień i aktualizacji na temat świadczonych usług – co przypomina bycie cyfrowym „prześladowaniem przez zmarłych” .”

Nawet ci, którzy początkowo pocieszają się „martwym robotem”, mogą zostać wyczerpani codziennymi interakcjami, które stają się „przytłaczającym ciężarem emocjonalnym” – argumentują badacze, ale mogą też być bezsilni, jeśli chodzi o zawieszenie symulacji sztucznej inteligencji, jeśli ich nieżyjąca już bliska osoba podpisze długi umowę z usługą cyfrową dotyczącą życia pozagrobowego.

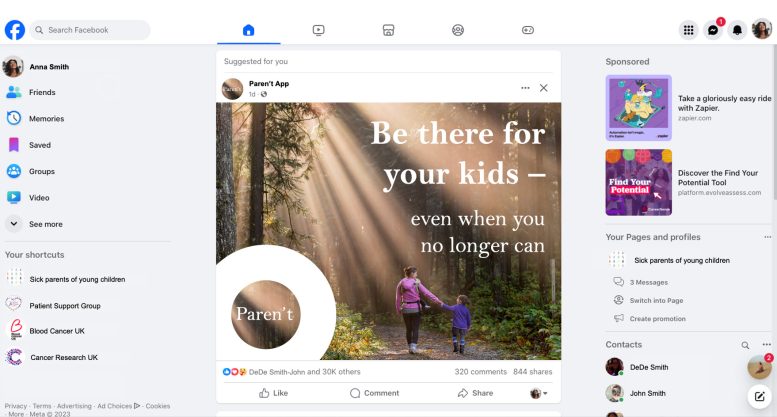

Wizualizacja fikcyjnej firmy o nazwie MaNana, jeden ze scenariuszy projektowych wykorzystanych w artykule w celu zilustrowania potencjalnych problemów etycznych w powstającej branży cyfrowej życia pozagrobowego. Źródło: dr Tomasz Hollanek

„Szybki postęp w dziedzinie generatywnej sztucznej inteligencji oznacza, że prawie każdy, kto ma dostęp do Internetu i podstawową wiedzę, może ożywić zmarłą bliską osobę” – powiedziała dr Katarzyna Nowaczyk-Basińska, współautorka badania i badaczka w Leverhulme Center for the Future of Intelligence w Cambridge ( LCFI). „Ten obszar sztucznej inteligencji to etyczne pole minowe. Ważne jest, aby nadać priorytet godności zmarłego i zadbać o to, aby nie została ona naruszona na przykład przez motywy finansowe związane z cyfrowymi usługami związanymi z życiem pozagrobowym. Jednocześnie dana osoba może zostawić symulację sztucznej inteligencji jako prezent pożegnalny dla bliskich, którzy nie są przygotowani na przepracowanie swojego żalu w ten sposób. Prawa zarówno dawców danych, jak i osób wchodzących w interakcję z usługami AI po życiu powinny być w równym stopniu chronione”.

Istniejące usługi i hipotetyczne scenariusze

Istnieją już platformy umożliwiające odtwarzanie zmarłych za pomocą sztucznej inteligencji za niewielką opłatą, takie jak „Project January”, w ramach którego na początku wykorzystywano modele GPT przed opracowaniem własnych systemów, oraz aplikacje, w tym „HereAfter”. Podobne usługi zaczęły pojawiać się także w Chinach. Jednym z potencjalnych scenariuszy przedstawionych w nowym artykule jest „MaNana”: konwersacyjna usługa sztucznej inteligencji umożliwiająca tworzenie martwego bota symulującego zmarłą babcię bez zgody „dawcy danych” (martwego dziadka).

W hipotetycznym scenariuszu dorosły wnuk, który początkowo jest pod wrażeniem i pocieszony technologią, zaczyna otrzymywać reklamy po zakończeniu „płatnego okresu próbnego”. Na przykład chatbot sugerujący składanie zamówień w firmach dostarczających jedzenie głosem i stylem zmarłego. Krewny uważa, że zlekceważył pamięć swojej babci i pragnie wyłączyć martwego robota, ale w znaczący sposób – czego usługodawcy nie wzięli pod uwagę.

„Dzięki takim symulacjom ludzie mogą wytworzyć silne więzi emocjonalne, co uczyni ich szczególnie podatnymi na manipulację” – powiedział współautor dr Tomasz Hollanek, również z LCFI w Cambridge. „Należy rozważyć metody, a nawet rytuały wycofywania martwych robotów z godności. Może to oznaczać na przykład formę cyfrowego pogrzebu lub inny rodzaj ceremonii w zależności od kontekstu społecznego. Zalecamy protokoły projektowe, które zapobiegają wykorzystywaniu martwych botów w sposób pozbawiony szacunku, na przykład do celów reklamowych lub aktywnej obecności w mediach społecznościowych.

Choć Hollanek i Nowaczyk-Basińska twierdzą, że projektanci usług rekreacyjnych powinni aktywnie zabiegać o zgodę dawców danych przed ich przekazaniem, o tyle ich zdaniem zakaz stosowania martwych botów w oparciu o dawców nie wyrażających zgody byłby niewykonalny.

Sugerują, że procesy projektowania powinny obejmować szereg podpowiedzi dla tych, którzy chcą „wskrzesić” swoich bliskich, np. „czy kiedykolwiek rozmawiałeś z X o tym, jak chciałby, aby go zapamiętano?”, tak aby godność zmarłego była na pierwszym planie w rozwoju martwego bota.

Ograniczenia wiekowe i przejrzystość

Inny scenariusz przedstawiony w artykule, dotyczący wyimaginowanej firmy o nazwie „Paren’t”, uwypukla przykład nieuleczalnie chorej kobiety opuszczającej martwego robota, aby pomóc swojemu ośmioletniemu synowi w procesie żałoby.

Chociaż martwy robot początkowo pomaga jako pomoc terapeutyczna, sztuczna inteligencja zaczyna generować mylące odpowiedzi, dostosowując się do potrzeb dziecka, na przykład przedstawiając zbliżające się osobiste spotkanie.

Badacze zalecają ograniczenia wiekowe dla martwych robotów, a także wzywają do „znaczącej przejrzystości”, aby zapewnić użytkownikom stałą świadomość, że wchodzą w interakcję z sztuczną inteligencją. Mogą one być podobne do obecnych ostrzeżeń dotyczących treści, które mogą powodować na przykład drgawki.

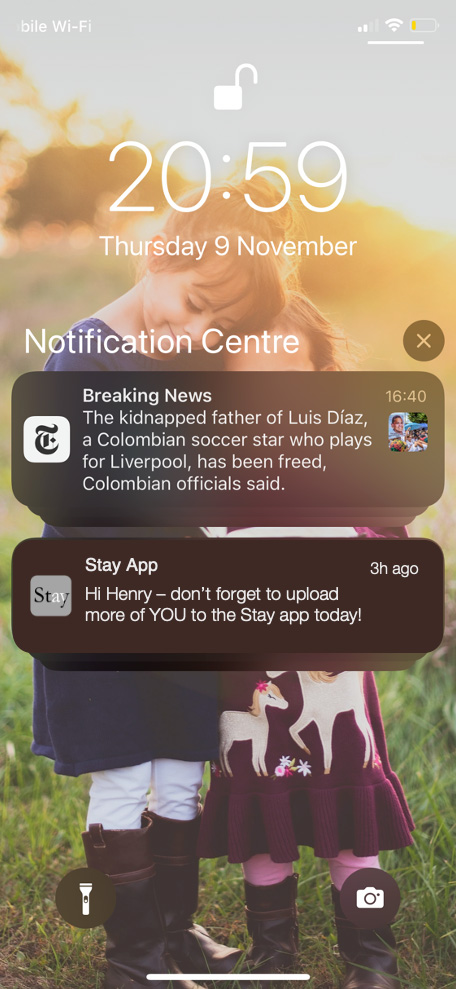

Ostatni scenariusz zbadany w badaniu – fikcyjna firma o nazwie „Stay” – przedstawia starszą osobę, która potajemnie angażuje się w działanie martwego bota i płaci za dwudziestoletnią subskrypcję w nadziei, że pocieszy to jej dorosłe dzieci i umożliwi wnukom znam ich.

Usługa rozpoczyna się po śmierci. Jedno dorosłe dziecko nie angażuje się i otrzymuje mnóstwo e-maili pisanych głosem zmarłego rodzica. Inny tak robi, ale kończy się wyczerpaniem emocjonalnym i poczuciem winy z powodu losu martwego robota. Jednak zawieszenie martwego robota naruszyłoby warunki umowy podpisanej przez jego rodzica z firmą usługową.

„Ważne jest, aby cyfrowe usługi związane z życiem pozagrobowym uwzględniały prawa i zgodę nie tylko tych, które odtwarzają, ale także tych, którzy będą musieli wchodzić w interakcję z symulacjami” – stwierdziła Hollanek.

„Usługi te wiążą się z ryzykiem spowodowania ogromnego cierpienia u ludzi, jeśli staną się ofiarami niechcianych cyfrowych nawiedzeń spowodowanych niepokojąco dokładnymi rekonstrukcjami AI osób, które utraciły. Potencjalny efekt psychologiczny, szczególnie w i tak już trudnym momencie, może być druzgocący”.

Badacze wzywają zespoły projektowe do nadania priorytetu protokołom rezygnacji, które umożliwiają potencjalnym użytkownikom zakończenie relacji z martwymi robotami w sposób zapewniający emocjonalne zamknięcie.

Dodała Nowaczyk-Basińska: „Musimy już zacząć myśleć o tym, jak złagodzić społeczne i psychologiczne ryzyko cyfrowej nieśmiertelności, ponieważ technologia już jest”.

Odniesienie: „Griefbots, Deadbots, Postmortem Avatars: on Responsible Applications of generative AI in the Digital Afterlife Industry” Tomasza Hollanka i Katarzyny Nowaczyk-Basińskiej, 9 maja 2024 r., Filozofia i technologia.

DOI: 10.1007/s13347-024-00744-w

/cdn.vox-cdn.com/uploads/chorus_asset/file/23986640/acastro_STK092_04.jpg?w=238&resize=238,178&ssl=1)